Spis treści

Z ostatnich danych firmy doradczej PMR wynika, że pandemiczny 2020 r. był najlepszym od czterech lat dla rynku centrów danych w Polsce pod względem podaży nowej powierzchni tego typu obiektów.

Nie dziwi to, w sytuacji, w której na masową skalę upowszechniła się zdalna praca i nauka, w siłę rosną muzyczne i filmowe platformy streamingowe oraz media społecznościowe, a coraz więcej zakupów dokonujemy w sieci. Cyfryzacja wszystkich aspektów życia znacząco przyspieszyła – nawet w skostniałej w wielu miejscach administracji państwowej i samorządowej.

Jednocześnie to dopiero początek kolejnej fali dużych inwestycji, które w perspektywie 2026 r. podwoją moc polskich centrów danych – jak przewiduje PMR – do ponad 180 MW.

Gonimy Zachód

Polskie centra powstają przede wszystkim w Warszawie i jej okolicach, ale też na Górnym Śląsku, Trójmieście, Wrocławiu, Krakowie i Poznaniu. Na początku 2021 r. wśród 40 największych obiektów w stołecznej aglomeracji znajdowało się ich 24.

Piotr Wójcik, dyrektor Działu Sprzedaży ds. Kluczowych Klientów na Polskę i kraje bałtyckie w firmie Vertiv, która jest m.in. dostawcą infrastruktury związanej z zasilaniem i chłodzeniem serwerowni, w rozmowie z portalem WysokieNapiecie.pl potwierdził, że rynek jest rozpędzony.

– Rozwój ten podąża za globalnym wzrostem zapotrzebowania na przestrzeń niezbędną do przechowywania coraz liczniejszych zasobów danych. Jednak fakt dość niskiej bazy, z której startowaliśmy w Polsce w porównaniu z choćby naszymi zachodnimi sąsiadami powoduje, że dynamika tego wzrostu u nas wychodzi dalece ponad średnią europejską – zastrzegł Wójcik.

– Ponadto dostępność w Polsce zasobów niezbędnych do budowy i działania obiektów data center w znacznie atrakcyjniejszych cenach niż na zachodzie Europy przyciąga coraz więcej światowych graczy na nasz rynek, a ci już operujący w Polsce zwiększają swój stan posiadania – dodał.

Rozdrobniony rynek

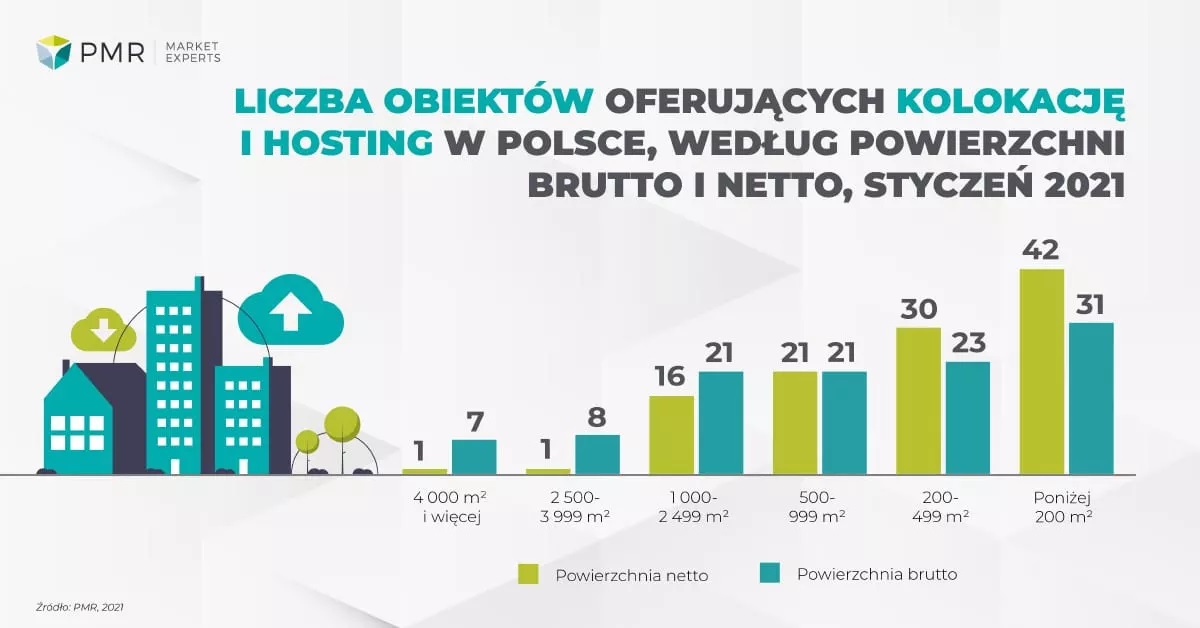

Z informacji PMR wynika, że zdecydowaną większość centrów przetwarzania danych w Polsce nadal stanowią obiekty małe, o powierzchni poniżej 200 m kw.

Jeśli uwzględniać powierzchnię wyłącznie pod szafy rack, w których są przechowywane serwery, to takich obiektów na początku 2021 r. było 42. Natomiast dodając do tego serwerownie o powierzchni od 200 do 500 m kw. otrzymujemy w sumie 72 centra.

Na początku tego roku istniał w Polsce jeden komercyjny obiekt (Atman), którego metraż pod szafy przekracza 4 tys. m kw. i jeden w przedziale 2,5-4 tys. m kw. (T-Mobile), choć blisko wejścia w ten przedział był Beyond.pl z centrum o powierzchni 2,4 tys. m kw.

Największe data center w Polsce to w praktyce jednak kompleks kilku serwerowni, budowanych sukcesywnie przez Atman w kolejnych latach. W przypadku doliczenia do serwerowni również powierzchni towarzyszących obiektów, to obiektów o powierzchni ponad 4 tys. m kw. jest siedem, a tych w przedziale 2,5-4 tys. m kw. – osiem.

Energetyczny wampir

Centra danych oraz serwerownie pracują w trybie ciągłym, co powoduje, że moc pracujących tam urządzeń ma decydujący wpływ na opłaty za energię elektryczną.

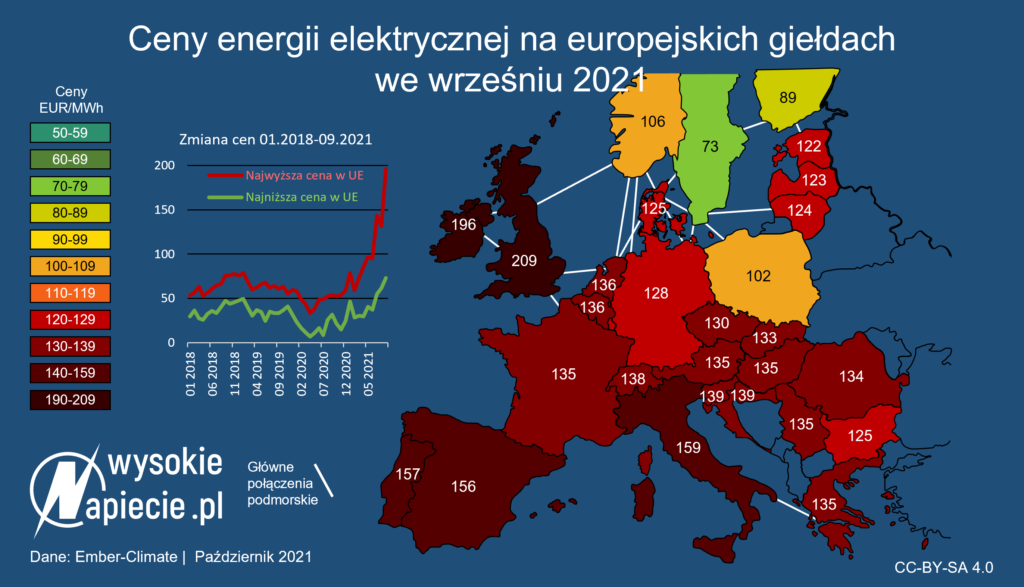

Zobacz też: Europa reaguje na gigantyczne wzrosty cen energii

– Aż 99,9997 proc. energii elektrycznej przeznaczanej na przetwarzanie danych jest zamieniane na ciepło w serwerowniach i centrach danych. Dodatkowym czynnikiem kosztowym są straty energii elektrycznej, generowane przez systemy zasilania gwarantowanego i dystrybucji – podkreślił Paweł Olszynka, dyrektor Działu Analiz Rynku ICT w PMR, w rozmowie z portalem WysokieNapiecie.pl.

Jak wyjaśnił, koszty energii elektrycznej generowane przez systemy zasilania i chłodzenia są głównym elementem składowym całkowitego kosztu utrzymania centrum danych – nawet do 40 proc. Rosnące ceny energii mobilizują więc do podnoszenia efektywności energetycznej.

– Firmy modernizują centra lub budują nowe, wyposażając je w bardziej nowoczesne rozwiązania. Szczególnie najwięksi dostawcy kładą nacisk na odpowiednio wysoki poziom sprawności zasilaczy UPS (zasilanie awaryjne – red.) i przetwornic zapewniających zmniejszenie poboru energii – wskazał Olszynka.

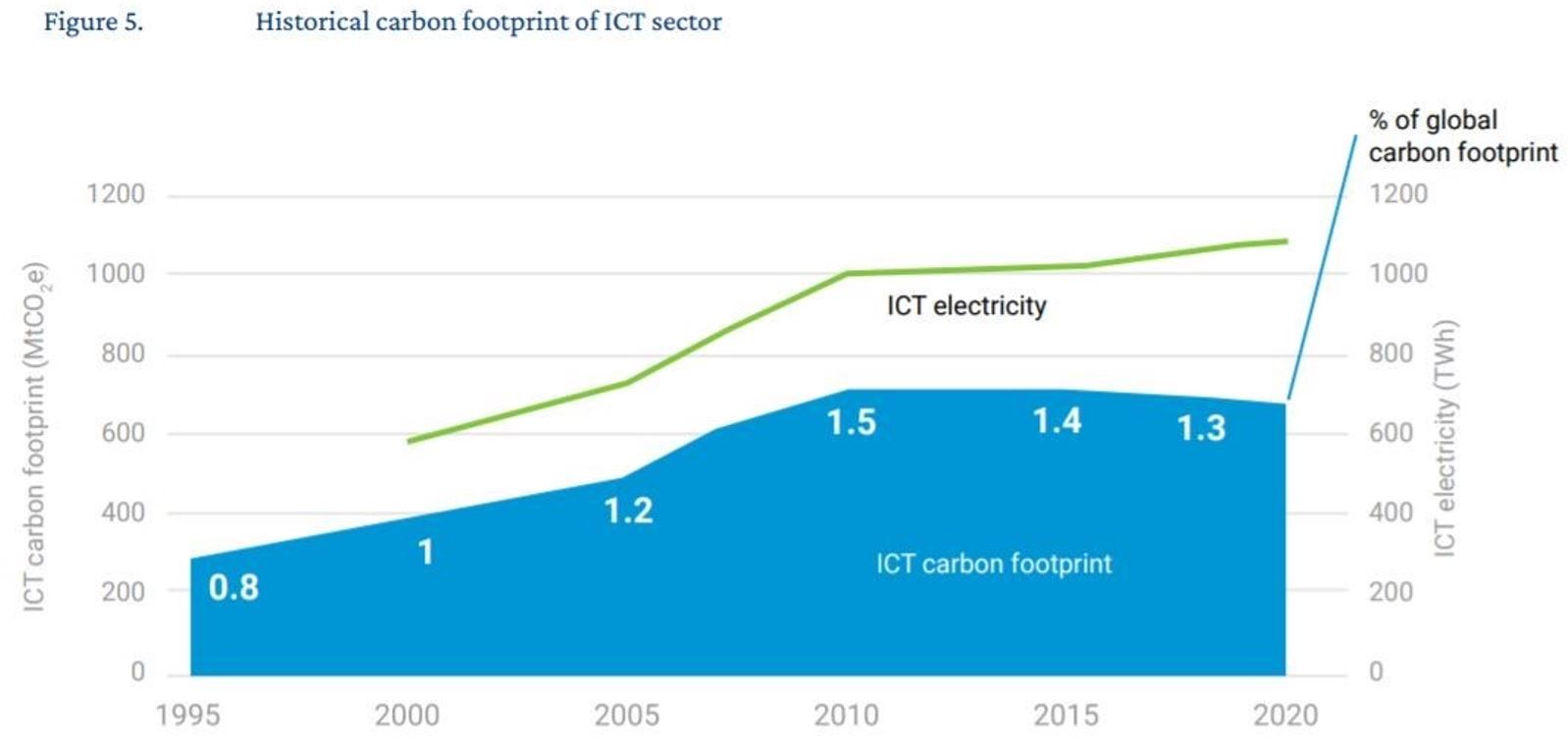

Węglowy ślad

Internet, a zatem i centra danych, wraz ze swoim rozwojem pochłaniają coraz więcej energii. Ponieważ większość energii zużywanej w światowej gospodarce wciąż bazuje na paliwach kopalnych, więc udział sektora cyfrowego w globalnych emisjach gazów cieplarnianych jest znaczący.

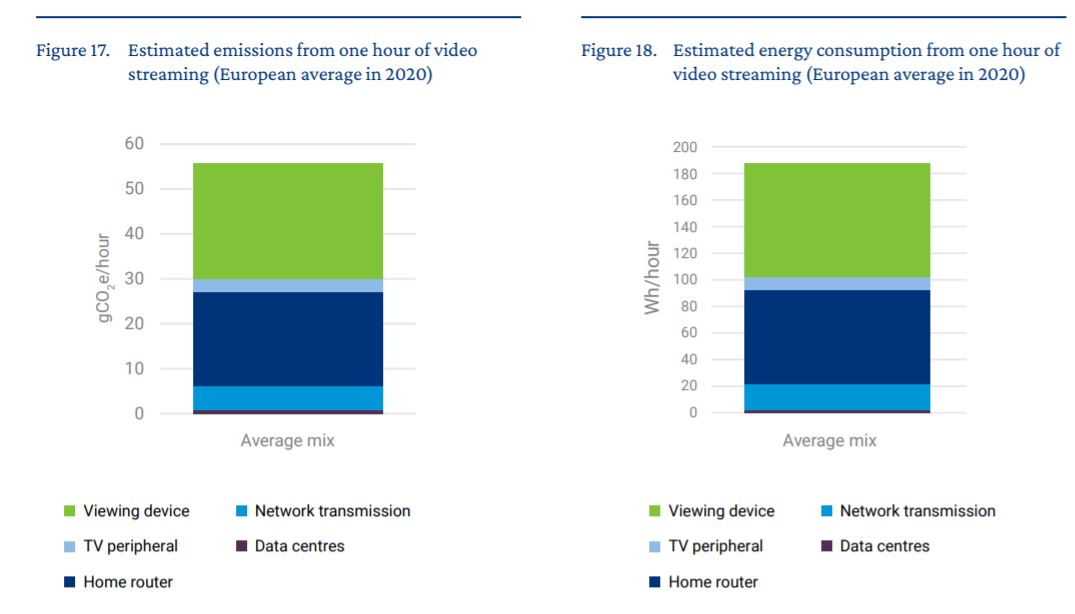

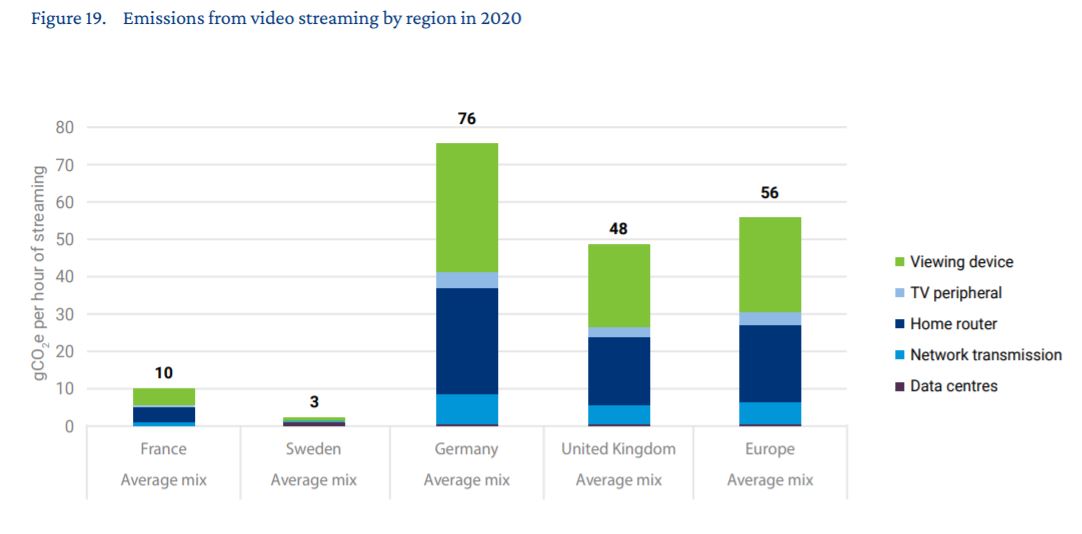

Według różnych wyliczeń, każdorazowe wykorzystanie internetowej wyszukiwarki oznacza emisję kilku gram CO2. Godzina oglądania filmu online to ponad 50 g. Rocznie cały sektor teleinformatyczny w skali globalnej odpowiada za co najmniej ponad 1 proc. emisji gazów cieplarnianych.

Piotr Wójcik z Vertiv zaznaczył, że jak najmniejszy ślad węglowy pozostawiany przez centra danych jest obecnie celem większości operatorów takich obiektów. Z jednej strony jest to podyktowane względami czysto ekonomicznymi, osiąganymi dzięki zastosowaniu wysokoefektywnych energetycznie urządzeń klimatyzacji precyzyjnej czy zasilania gwarantowanego.

Z drugiej strony powodem jest świadomość klientów, lokujących swoje serwery w centrach przetwarzania danych, na temat zanieczyszczenia środowiska wywołanego przez produkcję olbrzymiej ilości energii niezbędnej do poprawnego działania centrów. Wymusza to poszukiwanie odnawialnych źródeł energii do ich zasilania.

Efektywność priorytetem

Podobne obserwacje ma Paweł Olszynka z PMR, który zwraca też na wpływ zaostrzającej się polityki klimatycznej Unii Europejskiej.

– Polskie ośrodki data center coraz częściej wprost sygnalizują swoim klientom, że energia którą wykorzystują pochodzi z OZE. Potwierdzają to stosowne certyfikaty i gwarancje od dostawców energii, które poświadczają, że pochodzi ona ze źródeł odnawialnych. Najlepszym przykładem są liderzy rynku data center w Polsce: Beyond.pl, Equinix, Netia, Orange i T-Mobile – wskazał Olszynka.

Jak wyjaśnił, najczęściej dążą oni do tego, aby energia w 100 proc. pochodziła ze źródeł odnawialnych. Starają się też optymalizować wykorzystanie energii i ciepła.

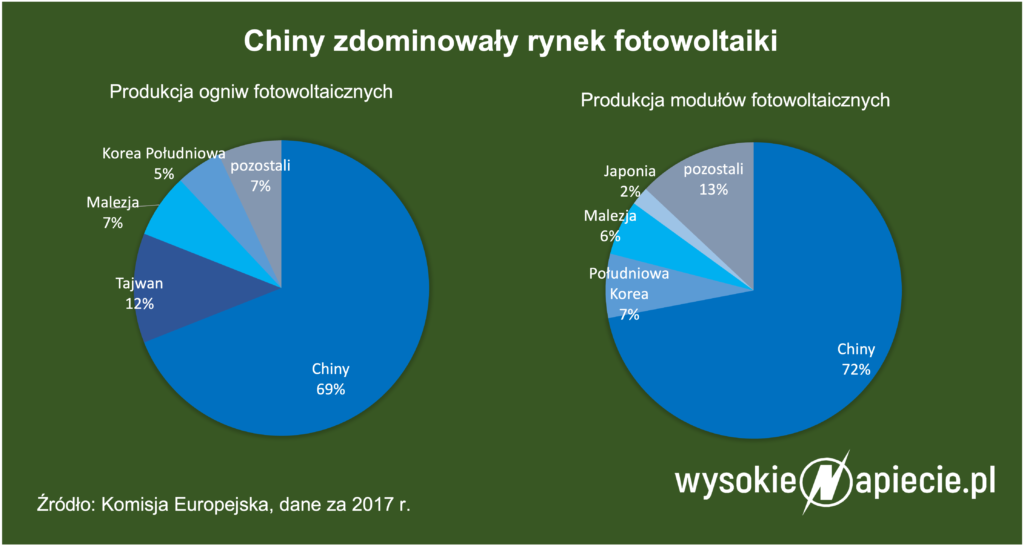

Przykładowo oba centra danych innego, dużego dostawcy działającego na polskim rynku, firmy Polcom, wykorzystują alternatywne źródła energii, takie jak fotowoltaika, położenie obiektu umożliwiające pasywne zyski ciepła, czy też wykorzystanie ciepła wytwarzanego przez urządzenia do ogrzewania biur i pomieszczeń poza serwerownią.

Z kolei spółka 3S zapewniła sobie dostęp do giełdy energii, dzięki czemu ma możliwość kupowania energii w sposób bardziej efektywny. Na inwestycję we własną farmę fotowoltaiczną o mocy 0,5 MW na potrzeby nowego centrum danych (Warsaw Data Hub) zdecydował się natomiast Orange.

Zobacz też: Inflacja rzuca cień na budowy farm wiatrowych i fotowoltaicznych

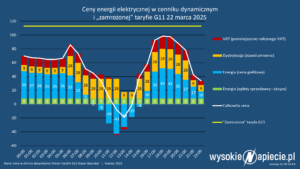

Paweł Olszynka podkreślił, że dostawcy data center szczegółowo analizują ceny energii i starają się być tutaj jak najbardziej konkurencyjni dla swoich klientów, którym najczęściej refakturują prąd zużyty przez urządzenia z odpowiednim narzutem w postaci współczynnika PUE (ang. power usage effectiveness – efektywność zużycia energii).

Współczynnik ten określa proporcje energii zużywanej na zasilanie centrum danych do energii pobieranej przez urządzenia IT. Im bliższy jest on wartości 1, tym mniejsze jest zapotrzebowanie centrum na energię dla klimatyzacji oraz pozostałej infrastruktury obiektu.

Ciepło, coraz cieplej

Zmiany klimatyczne odczuwalne są przez wszystkich, również przez operatorów centrów danych, co potwierdza Piotr Wójcik z Vertiv.

– W dużym stopniu z pomocą przychodzą nowe standardy temperaturowe wprowadzane przez producentów i użytkowników serwerów, pozwalające na ich pracę w temperaturze znaczenie wyższej niż do niedawna obowiązująca. Obecnie standardem jest 25°C i więcej, podczas gdy jeszcze nie tak dawno więcej niż 21-22°C uważane było za awarię – wyjaśnił.

Piotr Olszynka z PMR dodał, że najważniejszymi wyzwaniami są odpowiednio podniesione parametry temperaturowe urządzeń klimatyzacji precyzyjnej i dobór urządzeń wykorzystujących w możliwie największym stopniu funkcję tzw. free coolingu.

Pozwala ona na wykorzystanie w procesie chłodzenia temperatur panujących na zewnątrz serwerowni – schłodzenie „wody lodowej”, czyli czynnika chłodzącego w systemie klimatyzacji, następuje bez angażowania sprężarek chłodniczych.

– Oszczędności w tym przypadku mogą wahać się od 20 proc. do nawet 75 proc. Free cooling włącza się już przy temperaturze kilkunastu stopni powyżej zera, co w zasadzie pozwala na jego wykorzystanie – w mniejszym lub większym zakresie – niemalże w ciągu całego roku. Doświadczenia operatorów pokazują, że w Polsce występuje przeciętnie 5-10 nocy rocznie w porze letniej, kiedy wykorzystanie free coolingu nie jest w ogóle możliwe – stwierdził Olszynka.

Z inspekcji przeprowadzonych przez PMR wśród największych obiektów w kraju wynika, że z klimatyzacji precyzyjnej korzystano w 35 z 40 obiektów, natomiast 80 proc. największych centrów danych w Polsce stosuje free cooling jako element systemu chłodzenia serwerowni.

Olszynka wskazał, że dodatkowym elementem, który wykorzystują operatorzy, są systemy pozwalające na szczegółową analizę termiczną poszczególnych szaf w serwerowni.

Umożliwia to rozmieszczenie urządzeń w taki sposób, aby zapewnić im uzyskanie optymalnych warunków chłodzenia. Standardem jest aranżowanie serwerowni w systemie zimnych i ciepłych korytarzy, by zwiększyć efektywność chłodzenia całego układu.

Katastrofalne dane

Zmiany klimatyczne niosą za sobą również coraz gwałtowniejsze zjawiska pogodowe, które mogą przybrać postać klęski żywiołowej.

– Odpowiedzią na takie sytuacje, zmuszające w ostateczności do wyłączenia z pracy danego centrum danych, jest budowanie w niewielkiej lub większej odległości siatki obiektów pozwalających na szybki transfer danych pomiędzy nimi i tworzenie odpowiednich kopii danych. Stąd również wynika zwiększone zapotrzebowanie na nowe centra danych – podsumował Wójcik.